Após atingir 1,2 bilhão de downloads do modelo Llama 4, a Meta anunciou nesta terça-feira, 29, a API do Llama. Durante a conferência para desenvolvedores LlamaCon, o vice-presidente de inteligência artificial da companhia, Manohar Paluri, afirmou que a ideia da biblioteca é facilitar a forma de construir com o modelo multimodal.

Paluri reforçou que a tecnologia está disponibilizada para ser usada de forma rápida, customizada e sem lock-in, ou seja, o usuário pode usar a API para treinar ou fazer o fine-tuning de um modelo, baixar e usar em outra plataforma. Angela Fan, cientista e pesquisadora de IA generativa da Meta, afirmou que isso acontece devido aos controles e abertura que apenas um modelo open source permite.

O kit de desenvolvedor permite a criação com códigos em Python e TypeScript. Tem os modelos mais atualizados da Llama, o que inclui os novos modelos Llama Maverick 4 e Llama 4 Scout de texto e imagem, e modelos mais antigos como o Llama 3.3.

A API Llama está disponível a partir desta terça-feira, 29, em uma versão prévia. Os desenvolvedores que desejarem testar a ferramenta podem ser inscrever neste link e aguardar na fila de espera.

‘Open source é a chave’

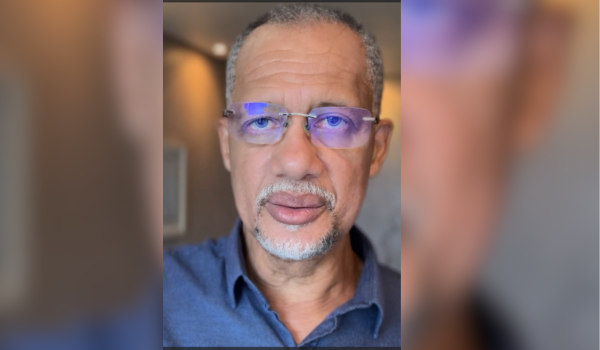

CEO e cofundador da Databricks, Ali Ghodsi (reprodução: Meta/LlamaCon)

Em conversa no evento com o CEO e cofundador da Meta, Mark Zuckerberg, o CEO e cofundador da Databricks, Ali Ghodsi, afirmou que os modelos de código aberto estão permitindo customizar casos de uso adaptados aos negócios o que coloca pressão para redução de preços no uso de grandes modelos de linguagem (LLM).

“Qualquer pessoa pode pegar um modelo como o Llama, usar e rodar em uma CPU. Isso significa queda de preço contínua e que libera muitos casos de uso em organizações afora”, disse Ghodsi. “Isso muda o jogo, pois quando os custos reduzem libera casos de uso que até então não eram possíveis”, completou ao citar os exemplos de uma linha de atendimento que usa IA para identificar riscos de suicídio em uma ligação e um prompt para analistas de mercado financeiro pedirem resultados por meio de terminais financeiros.

Por sua vez, Mark Zuckerberg cutucou o resto da indústria de IA e disse que toda vez que lançam uma versão nova do Llama os demais players reduzem o preço de chamadas para APIs.

Destilando e misturando modelos de IA

Mark Zuckerberg, CEO e cofundador da Meta (reprodução: Meta/LlamaCon)

Ghodsi disse ainda que o fato de o open source estar ganhando mercado está permitindo misturar, combinar e convergir diferentes modelos de IA para criar uma aplicação ou caso de uso. Deu como exemplo o DeepSeek, que os clientes da Databricks começaram a usar e misturar com o Llama. Detalhou que, em alguns casos, as empresas começavam a rodar um modelo com o R1 da DeepSeek, mas finalizam o trabalho com o modelo da Meta.

Zuckerberg reforçou que se DeepSeek ou Qwen (Alibaba) é melhor em uma tarefa, os desenvolvedores podem pegar a melhor de uma inteligência em diferentes modelos de código aberto e produzir exatamente o que precisa. Mas com o ecossistema ficando mais poderoso e complexo, as empresas como Databricks devem produzir ferramenta para “destilar”, ou seja, capturar trechos específicos de um modelo.

“Eu acho que esse é o diferencial do Open Source ante o modelo fechado. Você (desenvolvedor) não precisa pegar um modelo de prateleira ou destilar aquela base grande. É possível conseguir isso ao pegar as partes que precisa de um número crescente de modelos abertos”, completou o CEO da Meta.

Imagem principal: VP de IA da Meta, Manohar Paluri (blusa escura); Angela Fan, cientista e pesquisadora de IA generativa da Meta (reprodução: Meta/LlamaCon)