Fato: todo governo gosta de um vigilantismo estatal, mas poucos deixam isso tão escancarado quanto o Reino Unido e a China. O País do Meio foi pioneiro, antes do boom da Inteligência Artificial (IA), ao desenvolver um sistema baseado em algoritmo capaz de monitorar os hábitos de cidadãos específicos e prever seu comportamento futuro, como forma de deter dissidentes antes que estes causem problemas.

A terra do Rei, por sua vez, aprovou em 2023 uma controversa Lei de Segurança Online, de modo a ter acesso às mensagens e conversas criptografadas de todos os usuários do planeta, e agora, o Ministério da Justiça anunciou estar trabalhando em uma solução preditiva similar à chinesa, que usa IA para determinar quando um cidadão comum poderá cometer um assassinato.

Já deu de referências a Minority Report (Crédito: Reprodução/acervo internet)

A IA pre-cog do Reino Unido

A existência do programa para o desenvolvimento de uma IA preditiva foi revelada pelo Statewatch, uma instituição sem fins lucrativos que apoia campanhas em prol da liberdade civil e de imprensa, através de atos que vão de jornalismo investigativo a análises políticas, debates públicos, campanhas e outros movimentos sociais.

O órgão teve acesso a documentos detalhando o projeto, via solicitação de acesso via mecanismo de Liberdade de Informação, similar aos Portais de Transparência dos governos federal, estaduais, e municipais brasileiros, quando estes funcionam. Os arquivos acessam sugerem que as autoridades britânicas estão desenvolvendo a ferramenta com bancos de dados dos Ministérios do Interior e da Justiça, da Polícia da Grande Manchester, e da Polícia Metropolitana de Londres, que reúnem informações de 100 mil a 500 mil cidadãos.

A direção da pesquisa, segundo o Statewatch, foca em prever comportamentos de suspeitos, mas também possivelmente de vítimas e testemunhas; o governo nega, dizendo que ele seria empregado apenas “para fins de pesquisa”, com dados vindo apenas do Serviço Prisional e de Liberdade Condicional de Sua Majestade, o órgão do Ministério da Justiça responsável pelo sistema carcerário britânico, e usaria informações apenas de quem já foi condenado pelo menos uma vez no Reino Unido.

A IA em questão seria voltada a identificar, entre a massa de dados, comportamentos passíveis de evoluir de forma drástica, levando a uma ofensa criminal grave, no caso, homicídio. O projeto foi originalmente nomeado como “Projeto para Predição de Homicídios”, sendo alterado depois para o muito mais sutil “Compartilhamento de Dados Para a Melhoria de Análise de Risco”, embora sua função siga inalterada.

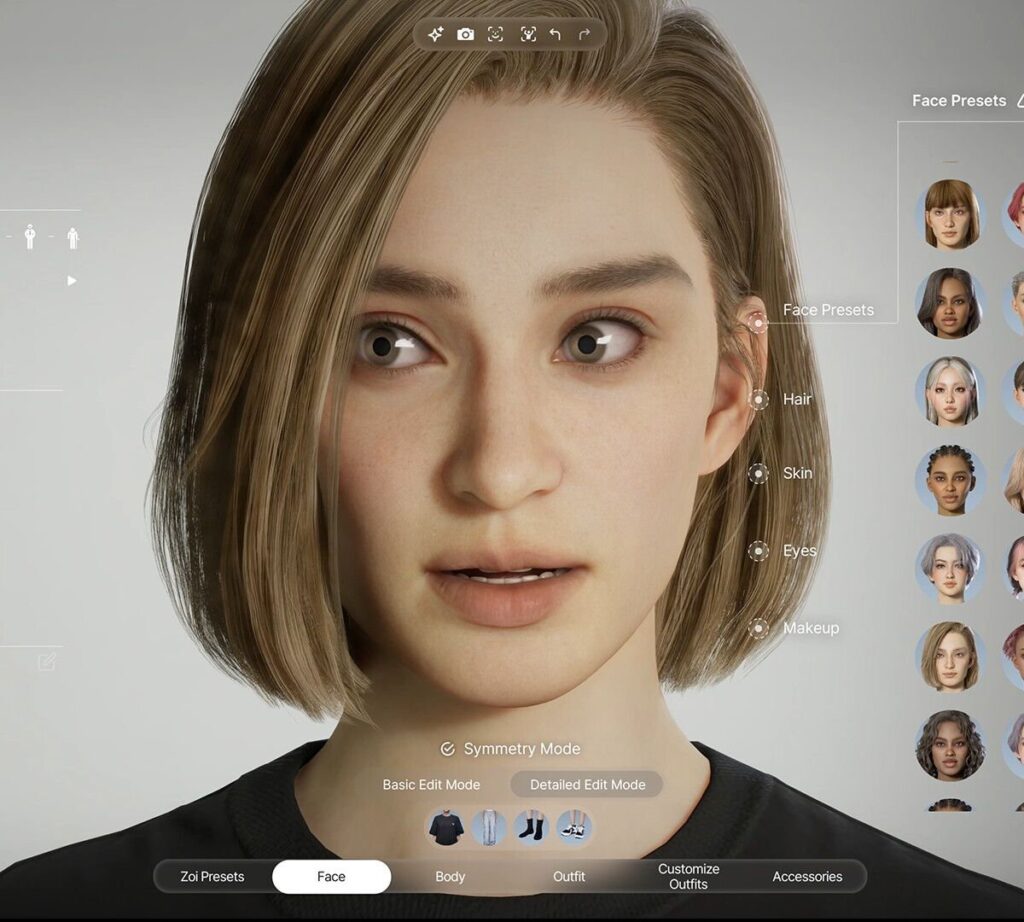

Segundo o Statewatch, algoritmo voltado a prever crimes pode reforçar preconceitos (Crédito: Reprodução/acervo internet)

Os documentos acessados pelo Statewatch mostram que os dados categorizados pelo algoritmo são bem específicos, como nome, data de nascimento, gênero, etnia, bem como vários tipos de condenações, a primeira vez que a polícia registrou um indivíduo como vítima (o que abre brecha para o uso de dados de inocentes), incluindo em casos de violência doméstica.

Há também uma seção para a categorização de “dados especiais”, no caso informações médicas que incluem dependência química, saúde mental, situações de vulnerabilidade, que incluem suicídio e automutilação, e deficiências físicas.

Para Sofia Lyall, pesquisadora do Statewatch, os documentos mostram que os dados usados para uma IA preditiva podem reforçar preconceitos, permitindo a categorização de cidadãos com base na cor de pele, gênero, status social, características físicas, ou por outros dados (orientação sexual, por exemplo), e chama o projeto todo de “um exemplo distópico arrepiante” de um experimento de algoritmo para vigilância e controle da população, mesmo com algoritmos do tipo “tendo se provado, ao longo do tempo, todos falhos”.

O governo do Reino Unido diz que o sistema de condicionais já usa ferramentas para análise de risco, e que a IA em questão não deve ser colocada em produção, mas estamos falando do país que quer ter o direito irrestrito de fuçar as mensagens online de todos os usuários do planeta, logo…

Fonte: The Guardian